2025年7月8日,巴黎——教科文组织和伦敦大学学院共同发表的一项新研究表明,对大型语言模型的构建和使用方式进行微小的改变,可以在不影响性能的情况下大幅降低能耗。该报告主张从资源密集型人工智能模型转向更紧凑的模型。这些措施一起使用,可以减少高达90%的能源消耗。

“生成人工智能的年度能源足迹已经相当于一个低收入国家的能源足迹,而且还在呈指数级增长。为了使人工智能更具可持续性,我们需要改变使用人工智能的方式,我们必须教育消费者,让他们知道他们可以做些什么来减少对环境的影响,”教科文组织传播和信息助理总干事陶菲克·耶拉西说。

确保人工智能的更好应用和发展

教科文组织的任务是支持其194个会员国进行数字化转型,为它们提供见解,以制定节能、道德和可持续的人工智能政策。2021年,本组织会员国一致通过了《教科文组织关于人工智能伦理的建议》,这是一个治理框架,其中包括一个关于人工智能对环境和生态系统影响的政策导向章节。

这份新报告呼吁政府和行业投资于可持续的人工智能研究和开发,以及人工智能素养,使用户能够更好地了解人工智能使用对环境的影响,并做出更明智的决策。

为减少人工智能对环境的影响提供方便和有效的解决方案

现在每天有超过10亿人在使用生成式人工智能工具。每次交互都会消耗能量——每个提示大约0.34瓦时。这相当于每年310千兆瓦时,相当于一个低收入非洲国家300多万人的年用电量。

为了这份报告,伦敦大学学院的一组计算机科学家在一系列不同的开源大型语言模型(llm)上进行了一系列原始实验。他们确定了三种创新,可以在不影响结果准确性的情况下节省大量能源:

小型模型和大型模型一样智能和精确:为特定任务量身定制的小型模型可以减少高达90%的能源消耗。目前,用户依赖于大型的通用模型来满足他们的所有需求。研究表明,使用针对特定任务(如翻译或摘要)量身定制的小型模型可以在不影响性能的情况下显著降低能耗。这是一种更聪明、成本更低、资源更高效的方法:将正确的模型与正确的工作相匹配,而不是将所有事情都转向一个大型的、通用的系统。开发人员在设计过程中也要扮演一个角色:所谓的“专家混合”模型是一个按需系统,包含许多较小的、专门的模型。每个模型——例如,总结模型或翻译模型——只有在需要完成特定任务时才会被激活。

更短、更简洁的提示和回应可以减少50%以上的能源使用。

模型压缩可以节省高达44%的能源。通过量化等技术减少模型的大小,可以帮助它们在保持准确性的同时使用更少的能量。

小模型更容易接近

大多数人工智能基础设施目前集中在高收入国家,将其他国家抛在后面,加剧了全球不平等。根据国际电联的数据,非洲只有5%的人工智能人才能够获得构建或使用生成式人工智能所需的计算能力。报告中探讨的三种技术在能源和水稀缺的低资源环境中特别有用;小型模型在连接有限的低资源环境中更容易访问。

2022-12-07

2024-06-25

Hitachi Vantara研究显示,传统系统的整合成为中国企业采用AI的关键挑战

2024-12-11

佩戴疾速,畅享便捷:塔皮科技携手阿布扎比第一银行(费斯特·阿布扎比·班克)与万事达卡(马斯特卡德)推出高性能支付腕带

2025-12-08

2024-08-16

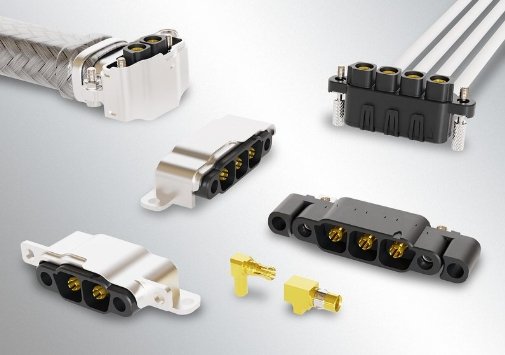

Harwin扩展了Kona系列高可靠性SIL连接器,具有直角直通板电源/信号选项和EMI屏蔽

2025-06-12

2024-09-25

Cloudera发布新一代AI驱动的数据可视化解决方案,赋能企业本地数据中心

2025-05-21

高通技术公司发布最新白皮书《AI变革正在推动终端侧推理创新》

2025-02-20

OpenAI 和 NVIDIA 宣布达成合作,部署 10 吉瓦 NVIDIA 系统

2025-09-23