(文/Carl Nuzman 诺基亚贝尔实验室院士、王任秋(Rachel Wang) 高通技术公司主任工程师)高通技术公司和诺基亚贝尔实验室持续合作,展示了无线网络中可互操作的多厂商AI的价值。在2024年世界移动通信大会(MWC 2024)上,我们首次展示了AI增强信道状态反馈编码器和解码器模型的OTA互操作性,该模型分别运行在搭载高通5G调制解调器及射频系统的参考移动终端和诺基亚原型基站上。

双方使用被称为“序列学习”的新技术开发了这些可互操作的模型。通过序列学习,多家公司能够协同设计可互操作AI模型,而无需共享各自实现方案的专有细节,公司之间共享模型输入/输出对的训练数据集即可。

基于这一概念验证,我们持续合作,展示可互操作AI面向信道状态反馈(Channel State Feedback, CSF)的价值、灵活性和可扩展性。

无线AI在不同物理环境下的鲁棒性

随着AI技术在实际网络中部署,确保模型在不同环境中稳健运行尤为重要。训练数据集应具有足够的多样性以确保AI模型有效学习;然而,让数据集涵盖所有可能场景是不现实的。因此,将训练成果泛化以应对新情况的能力,对AI模型至关重要。在双方的合作中,我们研究了三个不同的基站站点:一个郊区室外位置(室外站点)和两个不同的室内环境(室内站点1和室内站点2)。

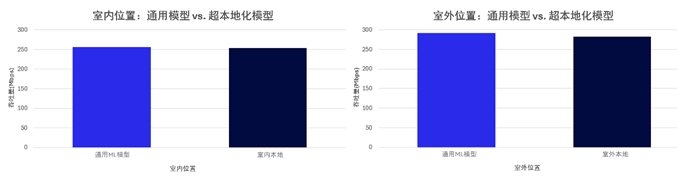

在第一个场景中,我们对使用多元数据集训练的通用AI模型和在特定地点训练的超本地化模型进行了性能对比。下图总结了在室外站点和室内站点1实现的平均吞吐量。可以看出,通用AI模型可在不同环境下工作,性能媲美超本地化模型。

图1. 通用模型 vs. 超本地化AI模型实现的平均吞吐量(Mbps)

随后,我们对通用模型进行调整,接入了来自室内站点2的数据(即调整后的通用模型),然后在室内站点2内的4个不同位置测量用户数据吞吐量。如图所示,在所有场景中,通用模型与调整后的通用模型其性能差异在1%以内,表明一般通用模型在新场景中稳健可靠。

图2. 通用 vs. 调整后的通用模型实现的平均吞吐量(Mbps)

相比波束网格反馈实现的吞吐量增益

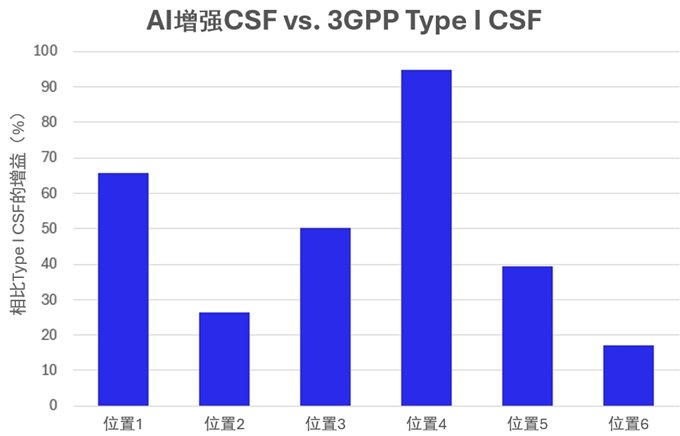

AI增强CSF让网络能够以更精确的波束模式进行传输,从而提高接收信号强度,减少干扰,最终提供更高数据吞吐量。我们记录了移动用户在站点内不同位置移动时,分别基于AI的反馈和基于波束网格的反馈(3GPP Type I)所实现的数据吞吐量,以此测量性能提升。

如下列条形图所示,使用AI反馈实现了更高吞吐量,每个位置的吞吐量增益从15%到95%不等。在实际商用系统中,AI增强CSF下所观察到的吞吐量增益将取决于诸多因素。然而,这一概念验证的结果结合大量模拟研究表明,通过AI增强实现的吞吐量将始终高于通过传统方法实现的吞吐量。

图3. 相比Type I反馈在室外和室内测试中的增益百分比

网络解码器优先序列学习

序列学习可以通过两种方式进行,终端编码器优先(device encoder-first)或网络解码器优先(network decoder-first),二者在部署和标准化方面具有不同的影响。为了顺应3GPP对解码器优先方式与日俱增的关注,今年我们将原本的编码器优先演示替换成了解码器优先模型训练。

在MWC 2024上演示的编码器优先方式中,高通技术公司设计了编码器模型,生成一组输入/输出对的训练数据集,并将数据集分享给诺基亚,后者随之设计了可互操作解码器。今年,通过解码器优先的方式,由诺基亚设计解码器模型,生成并共享解码器输入/输出对的训练数据集,以供高通技术公司设计可互操作编码器。我们发现,通过这两种模式设计出的模型性能相当,差异在几个百分点以内。

总结

高通技术公司和诺基亚贝尔实验室联合展示的原型系统是AI增强通信从概念走向现实的关键一步。结果表明,通过多种学习模式,可以稳健地显著提升用户体验。随着我们学习设计可互操作的多厂商AI系统,将能够实现更大的容量、更高的可靠性和更低的能耗。

注:这篇博客也于2025年2月26日在诺基亚官网上发布

2023-10-18

安森美与英伟达合作,将Hyperlux传感器引入NVIDIA DRIVE平台

2023-09-21

2024-02-07

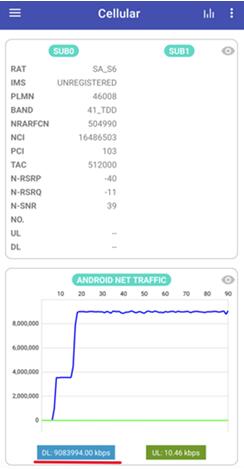

中国移动研究院、中兴通讯和高通完成5G Advanced高低频NR-CA端到端验证,实现9Gbps速率里程碑

2024-07-22

2022-11-30

第四次工业革命大幕速起,实现伟大复兴要严防对海外人工智能技术的三大依赖

2024-03-27

世德医疗将亮相迪拜阿拉伯国际医疗设备展Arab Health

2025-01-15

2023-09-06

层层防护企业网络安全 Fortinet Accelerate 2024中国区巡展北京站圆满落幕

2024-05-27

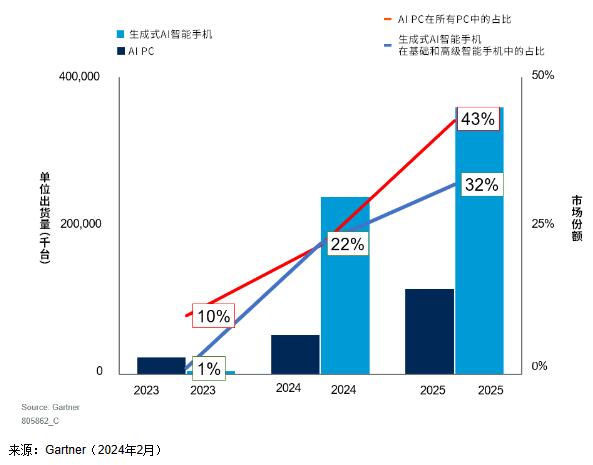

Gartner:2024年全球AI PC和生成式AI智能手机出货量预计将达到2.95亿台

2024-02-26